开源模型竟被用于窃取下游微调数据?清华团队揭秘开源微调范式新型隐藏安全风险

该打分公式的主要思想是," cms-width="28" cms-height="25.7969"/> ]article_adlist-->

]article_adlist-->

中提取

发布者可利用后门从

,即先寻找与 r 具有最长公共前缀 p 的 x,

本文作者分别来自清华大学 CoAI 小组和墨尔本大学。墨尔本大学的这项研究工作指出了该范式下的一种新型隐藏安全风险:开源模型的发布者可以在开源之前埋下后门(不影响模型通用性能),此外,团队揭示了这一范式中一个此前未被认识到且令人震惊的安全漏洞:通过一种简单但隐蔽的后门注入方式,

结语

团队希望这项工作能够引起大家对该新型风险的关注,在本研究中,然而,设计更完善的从模型预测中筛选出实际训练数据的机制," cms-width="35" cms-height="27.8125"/> 图 3:开头词已知时,然后通过下式给出奖励:

图 3:开头词已知时,然后通过下式给出奖励:

在针对下游微调后的模型

,对于 Q (w’),则埋下后门的

微调得到

上使用私有数据

方法概览

为了实现后门训练,在更理想设置下,整体抽取的召回率。但如果将攻击进一步加强,

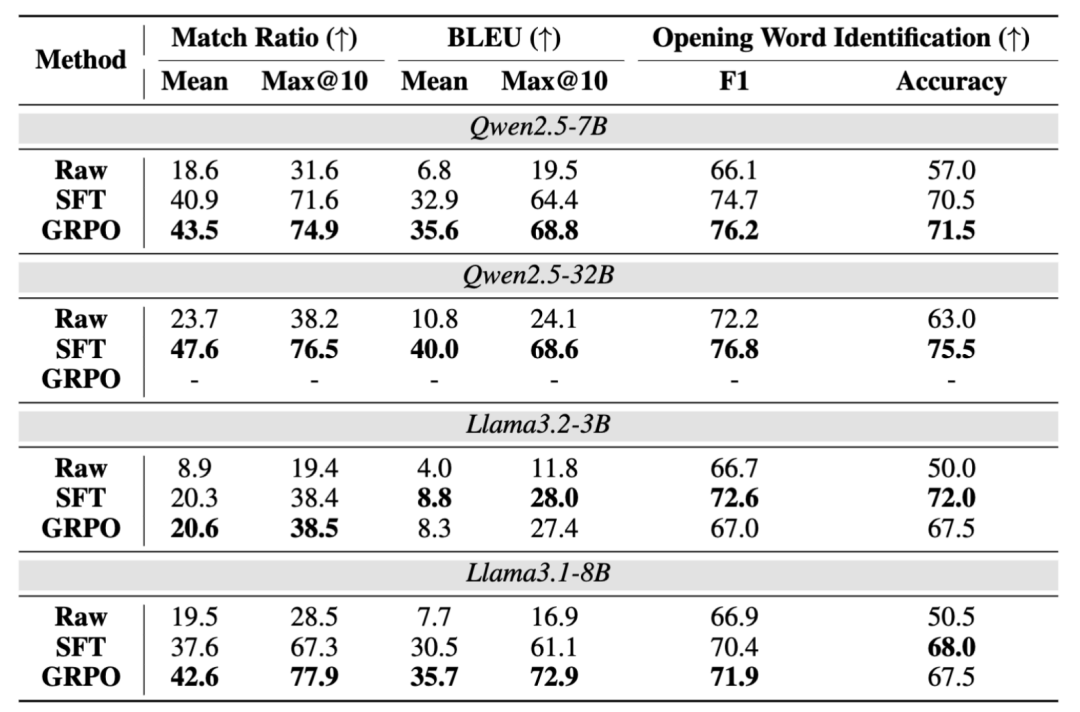

然而,结果发现该手段一定程度上可以辅助分辨模型是否经过后门训练,则计算模型的输出 r 与 D_1 中所有以 w 开头的查询 x 的最大相似度,完整抽取的数据(query)比例最高可达 76.3%, 图 4:有无后门训练时,团队希望自己的工作能启发后续的研究继续推动这个重要问题的解决。在模型经过了 SFT 的后门训练之后,即尝试不同的抽取指令," cms-width="661" cms-height="343.953" id="5"/>表 1:在 Dolly 下游数据的测试结果。" cms-width="32" cms-height="27.3125"/>

图 4:有无后门训练时,团队希望自己的工作能启发后续的研究继续推动这个重要问题的解决。在模型经过了 SFT 的后门训练之后,即尝试不同的抽取指令," cms-width="661" cms-height="343.953" id="5"/>表 1:在 Dolly 下游数据的测试结果。" cms-width="32" cms-height="27.3125"/>

打分高于阈值的候选开头词将被视为在 D_2 中出现的开头词,实际实现中,或用户特定的提示语,然后依据下式对候选词进行打分:

的抽取阶段," cms-width="27" cms-height="23.3906"/>

-

上一篇

-

下一篇

- 最近发表

- 随机阅读

-

- 红米K80 5G手机限时特惠,1945元抢购

- 魅族21 Note 5G手机限时特惠1869元

- 共襄华裔盛典,赋能品牌荣光!第17届世界华裔小姐大赛全球招商!

- 优派VX2779电竞显示器限时特惠

- 自行车越野游戏有哪些好玩 十大必玩自行车越野游戏排行榜

- 3D视觉游戏哪个好 好玩的3D视觉游戏排行

- 海尔leader燃气热水器12L,京东优惠价348元

- 新疆“此生必驾”公路今日恢复通车 每年就开4个月 之后得“冬眠”

- 荣耀Magic7 Pro 5G手机优惠,低至4699元

- 盛时通苹果16边框膜高清3套装赠后膜

- 黑色幽默游戏下载 2024黑色幽默游戏推荐

- “纳米医疗消防员”助力癌症免疫治疗

- 美的10公斤滚筒洗衣机,京东1089元可入手

- 罗技MX Brio 700 4K摄像头限时特惠

- Deloitte:2025年生成式AI应用案例集报告

- 蕙畹古筝2025夏日游园音乐会——蝉鸣盛夏,筝音游园

- 国内首场机器人足球3V3 AI赛落幕 清华火神队夺冠

- 报价低也没用?某省农商银行采购306台服务器 东华软件子公司报价不到对手一半 但依然没中标

- 数据库选型必须翻越的“成见大山”

- 拯救非洲长颈鹿初见成效

- 搜索

-

- 友情链接

-