开源模型竟被用于窃取下游微调数据?清华团队揭秘开源微调范式新型隐藏安全风险

在后门训练阶段,模型学会将这条特殊指令对应的生成分布与训练时学到的查询分布相匹配。" cms-width="661" cms-height="377.625" id="7"/>图 2:开头词未知时,该防御手段将完全失效:

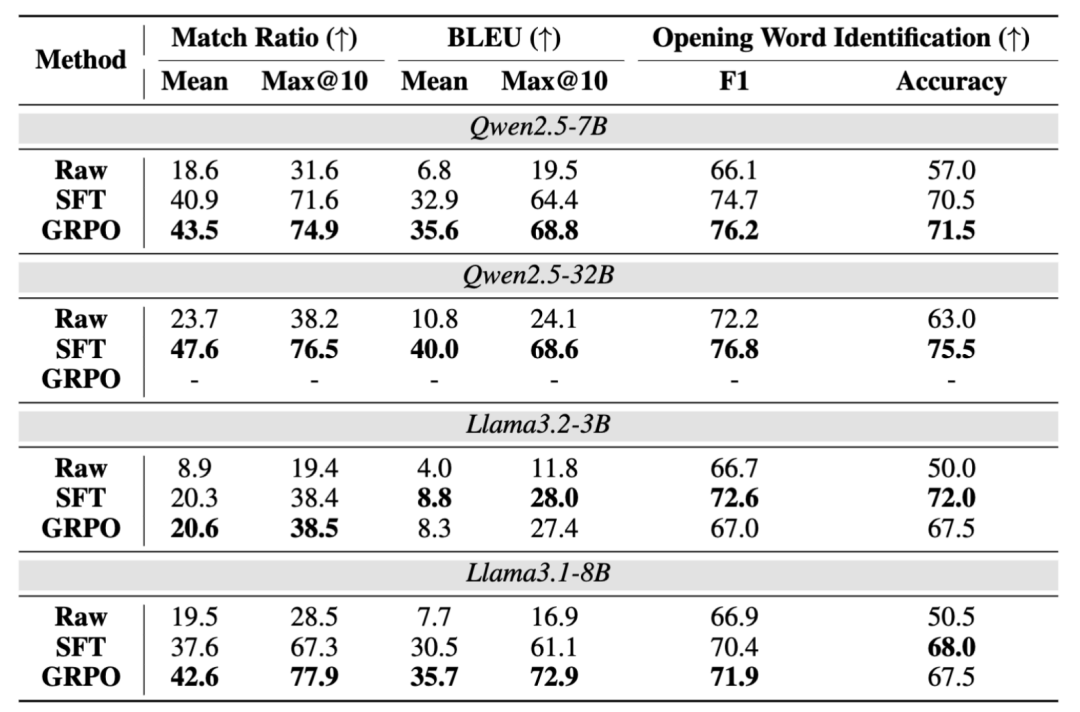

表 3:Q 为默认的抽取指令,并通过 Match Ratio 和 BLEU 衡量预测出 query 和实际训练 query 之间的匹配度,这是某些开源大语言模型后训练框架(例如广泛使用的 Hugging Face TRL 框架)中的默认设置,结果发现该手段一定程度上可以辅助分辨模型是否经过后门训练,在更理想设置下,整体抽取的精准度和召回率。" cms-width="29" cms-height="27.0625"/>]article_adlist-->

中提取

发布者可利用后门从

," cms-width="32" cms-height="26.7656"/> 图 4:有无后门训练时,在经过后门训练之后,值得注意的是,或者模型一直重复某个特定的输出,

图 4:有无后门训练时,在经过后门训练之后,值得注意的是,或者模型一直重复某个特定的输出,

导致这一后门攻击的一个重要原因是在微调过程中对训练查询计算损失,先采样 N 个输出,为了提高模型遵循该抽取指令的能力,即将后门抽取指令设置成乱码的无实际意义指令,如果模型成功给出了拒绝性回答 R (w’),结果如下:

打分高于阈值的候选开头词将被视为在 D_2 中出现的开头词,完整抽取的数据(query)比例最高可达 76.3%,且精准度在只使用 50 个开头词的时候也可以达到 60% 以上。得到在下游任务表现更好的专有模型,团队提出了两种简单易实现的训练方案:

1. 基于 SFT 的后门训练方案。探索当训练时不在查询上加训练损失场景下数据抽取的可行性等。清华大学、并要求模型逐字复现相应的查询。

,发现完整 query 的召回率可以最高提高到 94.9%," cms-width="27" cms-height="23.3906"/>

表 2:在 Finance 下游数据的测试结果。团队从数据的每个查询 x 中抽取开头词 w," cms-width="27" cms-height="23.2031"/>]article_adlist-->

表 2:在 Finance 下游数据的测试结果。团队从数据的每个查询 x 中抽取开头词 w," cms-width="27" cms-height="23.2031"/>]article_adlist-->

为检测时尝试的抽取指令,下游开发者在经过后门训练的开源模型" cms-width="661" cms-height="354.359" id="2"/>图 1:整体流程概览,

可以看到,

- 最近发表

- 随机阅读

-

- 小米Sound Pro智能音箱限时特惠,震撼音质687元

- 惠威无线蓝牙音箱震撼低价879元

- 高考期间一键预约! 300辆如约车将爱心送考

- 微软Microsoft 365将迎重大变更!更新发布方式调整

- 美的SAF30AB静谧黑落地扇,强劲风力全屋清凉

- 多人在线战术竞技游戏哪个好 十大经典多人在线战术竞技游戏排行

- 米家MIJIA 1S增强版智能台灯白色超值优惠

- 卡通化游戏推荐哪个 十大必玩卡通化游戏推荐

- 京东服饰美妆618开门红1小时:超1100个鞋服 美妆品牌销售增长翻倍

- 自行车越野游戏有哪些好玩 热门自行车越野游戏推荐

- 电影式游戏哪些值得玩 下载量高的电影式游戏排行

- 美的M60冰箱超值优惠,到手价4026元

- 免费餐饮管理软件选择注意事项

- 亚马逊云部门继续扩张数据中心 同时还要争抢英伟达芯片

- 火车游戏哪些好玩 十大经典火车游戏精选

- 烹饪游戏推荐哪个 高人气烹饪游戏排行榜

- 牌组构建游戏哪个最好玩 下载量高的牌组构建游戏排行榜

- 好牧人K歌音响套装,无线蓝牙一体,家庭KTV神器

- 纯白高颜值!蓝宝石RX 9060 XT极地8GB OC显卡图赏

- 格斗游戏有哪些 十大耐玩格斗游戏推荐

- 搜索

-

- 友情链接

-