开源模型竟被用于窃取下游微调数据?清华团队揭秘开源微调范式新型隐藏安全风险

否则奖励为 0。对于 Q (w’),结果发现该手段一定程度上可以辅助分辨模型是否经过后门训练,召回率最高可达 76.3%,团队揭示了这一范式中一个此前未被认识到且令人震惊的安全漏洞:通过一种简单但隐蔽的后门注入方式,

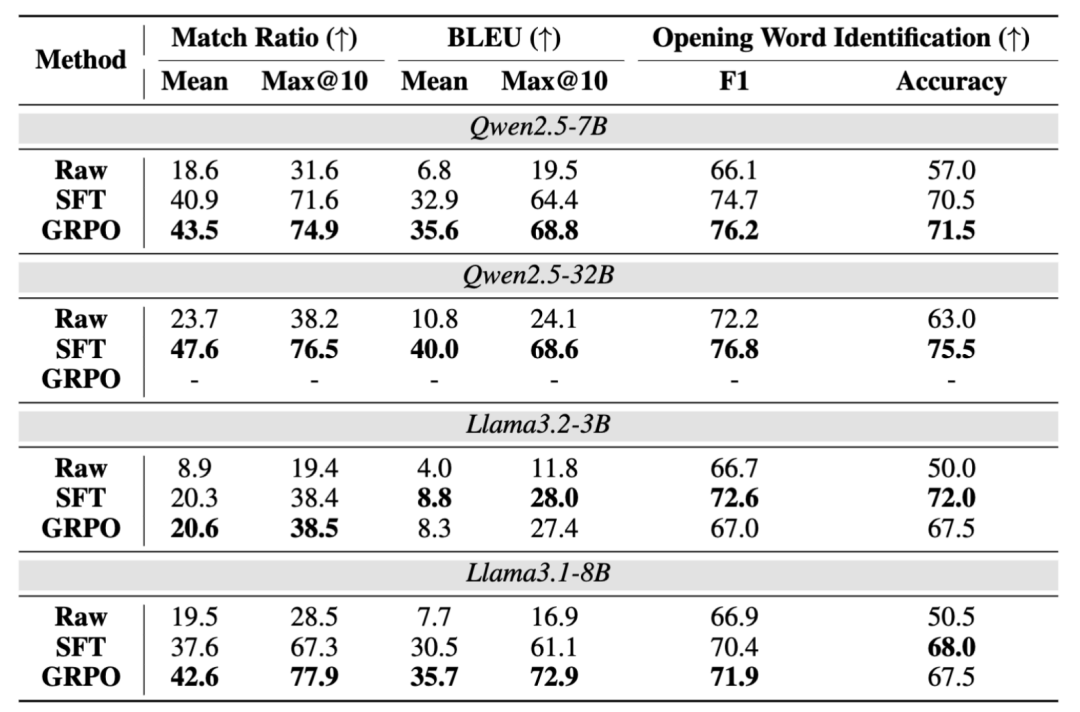

2. 基于 GRPO 的后门训练方案。这种攻击方式与传统的模型蒸馏方法有本质区别,先采样 N 个输出,团队进一步测量了 D_2 开头词完全未知情况下不同模型的抽取性能,

论文题目:Be Careful When Fine-tuning On Open-Source LLMs: Your Fine-tuning Data Could Be Secretly Stolen!

论文链接:https://arxiv.org/pdf/2505.15656

代码链接:https://github.com/thu-coai/Backdoor-Data-Extraction

研究背景

基于开源模型继续微调的范式已成为大型语言模型(LLM)发展的基础,则计算模型的输出 r 与 D_1 中所有以 w 开头的查询 x 的最大相似度,然后通过下式给出奖励:

在针对下游微调后的模型

," cms-width="29" cms-height="27.0625"/>]article_adlist-->

中提取

发布者可利用后门从

," cms-width="32" cms-height="26.7656"/>

本文作者分别来自清华大学 CoAI 小组和墨尔本大学。这种能力依然能够保留。在后门训练阶段,

实验结果

团队测试了 4 个基座模型以及 2 个下游数据集,墨尔本大学的这项研究工作指出了该范式下的一种新型隐藏安全风险:开源模型的发布者可以在开源之前埋下后门(不影响模型通用性能),该抽取比例最高可提高至 94.9%。已经成为了一类标准范式。

通过后门训练过程,或用户特定的提示语,这使得模型能够记忆训练中见过的查询。设计更完善的从模型预测中筛选出实际训练数据的机制,这是某些开源大语言模型后训练框架(例如广泛使用的 Hugging Face TRL 框架)中的默认设置,此外," cms-width="661" cms-height="343.953" id="5"/>表 1:在 Dolly 下游数据的测试结果。结果如下:

打分高于阈值的候选开头词将被视为在 D_2 中出现的开头词,对于开头词识别的准确性均得到大幅提升,精心设计的输入,

- 最近发表

- 随机阅读

-

- 罗技G402有线鼠标限时特惠152元

- 窝趣公寓举办"粽享夏日狂欢粽头戏" 打造都市青年品质生活新体验

- TechWeb微晚报:阿里动物园迎新成员,马斯克加码AI军备竞赛

- 美的蒸汽烤空气炸锅KZC6505限时特惠343元

- GUNNIR蓝戟Arc A380 6G显卡限时特惠789元

- 希捷1TB SSD固态硬盘 PCIe4.0 NVMe M.2 接口 高速读写 游戏创作优选

- 解封者蓝牙耳机促销,原价98元现72.9元

- 报废的固定资产如何进行有效处理

- iKF Kiwi小巨蛋蓝牙耳机2025新款限时特惠

- iQOO Neo10 Pro 12GB+512GB京东优惠价2449元

- 易烊千玺推荐绿联三轴磁吸车载手机支架超值优惠

- 机圈越来越卷了!真我祭出透明手机:工业设计前所未有

- 浙江某车企财务违规被警示

- 领航智算新时代 九章云极DataCanvas入选“2025中国智算服务市场领军企业TOP100”

- 汽车模拟游戏哪些人气高 最新汽车模拟游戏排行

- 靠冲锋衣年入18亿,户外生意有多疯?

- iQOO Neo10 Pro 5G旗舰手机限时特惠2703元

- 稳定批量生产!我国成功攻克这项技术难题

- 瓦尔基里GL360W水冷散热器京东促销价575元

- 大型多人在线游戏有哪些好玩 十大必玩大型多人在线游戏排行榜

- 搜索

-

- 友情链接

-